表情定位是微表情(ME)分析的基本步驟。至今為止收集的大多數微表情影片中,參與者大多保持頭部不動,且片長時間較短,這類短影片很少有其他種類頭部的動作,且光線變化等環境對圖像的影響也可以忽略不計。因此,微表情是短影片中比較明顯的動作,很容易被檢測到。

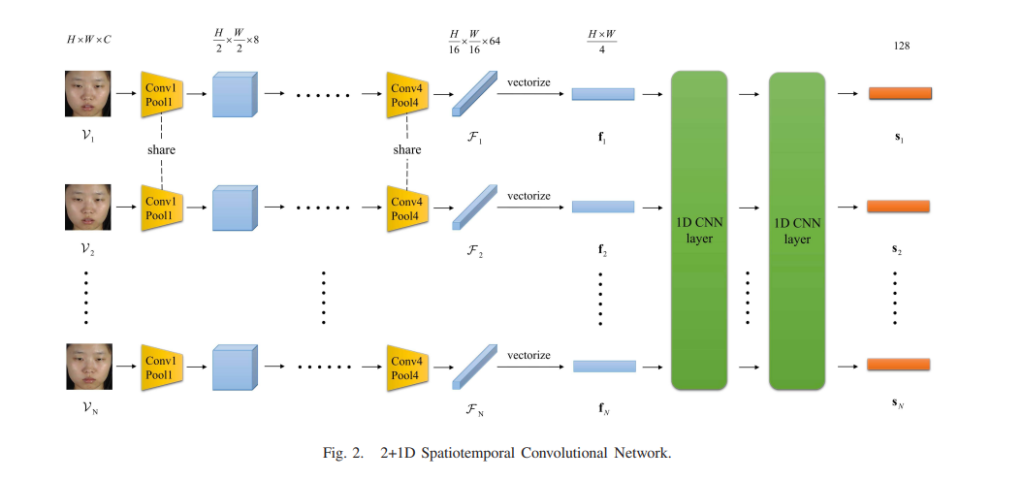

此研究提出一種基於卷積神經網絡 (CNN) 的新型網絡,其用於發現長影片中的多尺度自發微表情區間。我們將該網絡命名為 Micro-Expression Spotting Network (MESNet)。它由三個模塊組成。第一個模塊是2+1D時空卷積網絡,使用2D卷積提取空間特徵,1D卷積提取時間特徵。第二個模塊是 Clip Proposal Network,它給出了一些提議的微表情剪輯。最後一個模塊是分類回歸網絡(Classification Regression Network),它將提議的剪輯分類為微表情與否,並進一步回歸它們的時間邊界。

另外,該論文還提出了一種用於發現微表情的新評估指標。在 CAS(ME) 2 和 SAMM 這兩個長視頻數據集上進行了廣泛的實驗,並使用 leave-one-subject-out 交叉驗證來評估定位性能。結果表明,所提出的 MESNet 有效地增強了 F1-score 指標。比較結果表明,所提出的 MESNet 取得了良好的性能,優於其他最先進的方法。

總結來說,不僅提出一種基於CNN 的方法來發現長視頻中的多尺度ME 間隔,透過幾個特殊的技巧來處理小樣本量和樣本不平衡的ME 問題,並為ME發現提出了新的評估指標。

REF: MESNet: A Convolutional Neural Network for Spotting Multi-Scale Micro-Expression Intervals in Long Video

圖片來源:MESNet: A Convolutional Neural Network for Spotting Multi-Scale Micro-Expression Intervals in Long Video